1,360動画撮影をやってきた会社がバーチャルプロダクションをやり始める背景・動機

感染症によるオンラインエンタメへの需要増加 2020年春から流行している感染症により、実空間で提供していた各種エンターテインメントのオンラインシフトが進行しました。エンターテイメントの中でも演劇や舞台芸術は、動画でのライブストリーミングで配信されたり、音楽コンサートは3次元メタバース空間でのバーチャルコンサートが開催されています。社会環境の変化により、オンラインエンターテインメントへの需要が急増し、映像制作の現場においても対応や革新の要求が強くなってきました。

実写とCGの融合 劇場が閉鎖され、公演をオンラインで実施するに際して出てきた課題が、リアルな劇場でやっていた公演がオンラインでもそのまま成立するのか?オンラインに適用した公演・特徴付けとはどのようなものだろうか?といったものでした。リアル公演の制作費については、会場の座先数 x 稼働率 x 公演回数x チケット代の計算で、制作にかけられる最大費用が算出できます。この座席数やチケット代は、オンライン配信に比べて客数が多かったり、チケット代金も高額だったりすることから、相当な金額になってました。しかしオンライン配信では、対象となる視聴者がPCやスマホの操作になれたユーザ層に絞られたり、視聴者がかけられる予算感も数百円から数千円などと、劇場のチケット代より単価が低くなりました。これらの背景から公演の制作も劇場向けの規模を維持するのは難しく、出演者数を減らしたり、大道具・小道具の量も減るだろうという予測になりました。役者や大道具・小道具の量を削減しなければいけない中で、公演としての品質を下げずにやるには、バーチャル・デジタルな要素を足すことで、オンライン配信専用の公演制作をするのはいかがでしょうか。リアルな役者のテクスチャや動きは実写にて、背景や演出の一部をデジタルで実現することで、オンライン配信に向いたコンテンツ制作をできるのではないかと考え、バーチャルプロダクションの調査が始まりました。

ソフトウェア開発能力の可能性 バーチャルプロダクションの調査を進めると、スタジオでの実写撮影に加えて、その映像にリアルタイムでCGを合成するに際して、Unreal EngineやUnityといったゲームエンジンや、そのゲームエンジンから派生した専用ソフトウェアなどが必要ということがわかり、これならソフトウェア開発に専門性のある当社としても親和性がありそうだということになり、業界に貢献できるかもと考えました。

VIDEO

2,動画スタジオを始める際に必要な撮影機材(カメラ、レンズ、照明、ドリー等) バーチャルプロダクションを進めるにあたり、まずはスタジオの構築が必要になります。スタジオといっても、静止画のスタジオ、動画のスタジオ、音声収録のスタジオと世の中には多くの種類のスタジオが存在し、今回は実写映像とCGの合成を目指したスタジオなので動画撮影のスタジオになります。

カメラとレンズ 動画撮影のスタジオで使われるカメラはシネマカメラと呼ばれ、それらカメラで使われるレンズはシネマレンズまたはシネマレンズと呼ばれるようです。最近の一眼レフカメラでは、動画も撮れるようになってはきていますが、その多くのメーカー・機種において、最⻑記録時間に30分制限があったりします。それ以外にもシネマカメラの特徴には、音声録音のためのマイク系機能・インターフェイスがあったり、または動画に特化したピクチャープロファイルを選べたりと、やはり動画には動画専用のカメラを使う理由があります。

レンズについても同様で、特にバーチャルプロダクションでは、ズームレンズ使用時にズーム倍率によって開放値が変わらないこと、それによりズーム倍率を変えてもグリーンバックの抜け(キーイング)が変わらなくなったり、さらにカメラトラッキングシステムとの連携のためにレンズにギアがついているか等が必要条件になります。これらの要件にある製品として、当社ではSony FX6 とSony SELC1635G でまずは環境構築・制作フロー構築を開始しました。

照明(ライティング) バーチャルプロダクションにおける照明の役割は、メインの被写体である出演者を照らすだけでなく、グリーンバックカーテンを一様に照らすなどもあります。スタジオ照明の製品もピンからキリまであり、また数も必要になるので、実は撮影機材と同じかそれ以上に費用がかかってしまうのが照明だということもわかりました。バーチャルプロダクションの照明においては、後々リアルタイム合成等で用いるゲームエンジンやその他ソフトウェアから、3D CGで制作するバーチャルセット内の明るさや色に合わせられるようコンピュータからの制御が必要になり、DMX信号に対応した照明である必要性も出てきます。したがって演色性もあり、DMX対応の照明というのが要件になります。

ドリー・クレーン・ジブアーム 動画では、たとえ一つの被写体であっても、カメラのズーム、動き(カメラワーク)、スイッチング等を駆使することで、一つの被写体であっても複数視点で撮影することで魅力的な映像を作れます。スタジオでは複数のカメラを配置するだけでなく、一つ一つのカメラが動ける範囲を確保する、カメラがブレずに動ける手段を確保する必要があります。

カメラを手持ちにしつつ安定して撮影する機材として、ジンバルがあります。最近ではDJIのRoninシリーズやFeiyutechなどを人気かと思いますが、これらもカメラワークにバリエーションをつける良い選択肢の一つです。さらにダイナミックにカメラを動かしたい場合は、クレーンやジブアームといった人間の手足を超えた、大きな機械装置によりカメラの動きを作ることで、手ブレ等が発生することなく、斬新なカメラワークを実現できます。ドリーなどもスタジオ内にレールを引くことで、スムーズな水平移動を可能にする機材になります。

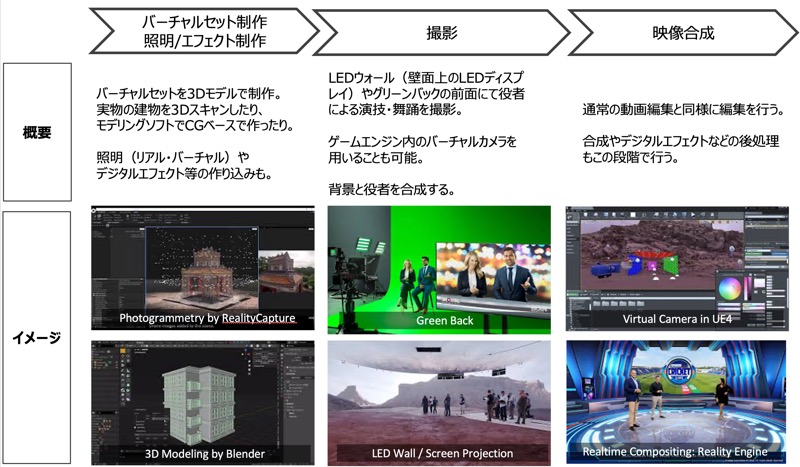

3,バーチャルプロダクションの概要(他者事例も含めて)

技術構成 バーチャルプロダクションを実現するにあたり、従来のスタジオ動画撮影と比較して、技術的に異なる点は以下のような事項になります。詳細については、次章以降で書きますが、ここではまずは概要だけ列挙します。

実写動画とCGのリアルタイム合成:これまではキーイングといって、グリーンバック等を用いて撮影し、後処理で背景のカーテンを削除して、そこにCG画像を表示して合成をしていました。これをリアルタイムに実現するところにバーチャルプロダクションの新規性があります。

作品事例・海外事例 バーチャルプロダクション手法を用いて制作されたメジャーな作品の一つとして、スターウォーズのドラマ作品であるマンダロリアン が挙げられます。この作品はバーチャルプロダクションの制作フローでよく活用されるUnreal Engineのデモ動画等でも取り扱われることも多いので、多くの関係者が参照する作品になっています。また、小規模なスタジオが制作されたであろう作品の一つに、VFXアーティスト IanHubert氏の新作『Dynamo Dream』 のティザー映像を挙げます。

この作品は、小型スタジオで撮影したであろうバーチャルプロダクション事例を探していたときに見つけたものですが、スタジオはそんなに広くないにも関わらず、役者さんの前後左右の動きや、映像内にエレベーター(昇降機)を設けることで、アパートの部屋、軽食売り場、駅のような3シーンの遷移が行われており、バーチャルプロダクションの可能性を感じさせてくれました。

国内事例

4,動画とCGの3次元的なリアルタイム合成(UE4 & Reality/Pixotopeを中心に) バーチャルプロダクションに使用するハードウェアが決まった後に決めるべき大きな決断の一つにソフトウェア環境をどのようにするかというのがあります。まずはベースに使用するゲームエンジンの選定ですが、これはUnityとUE4という選択肢があります。私達の場合は、リアルタイム合成ソフトウエアとの相性を優先して考え、UE4を選定。その上でリアルタイム合成ソフトウェアの選択肢を以下のように設定しました。

Zero Density:Reality Engine Future Group: Pixotope 国内で使用例が多く、日本語でのサポートが充実しているのはReality Engine。おそらく、低リスクで王道的に行くのでしたらこちらの選択肢になります。しかし、ライセンス形態が複数に分かれており、いろいろ揃えていくと高額になるのと、ソフトウェアのUI的な使い勝手としては必ずしもベストではありませんでした。現時点で使用しているのはPixotopeです。これは日本での導入事例は少なくとも2021年春頃のメーカー側の返答としてはないらしく、しかしUIが直感的で、オンラインのサポートミーティングでも親切だったということで、進めています。

5,カメラトラッキングシステム(RedSpyを中心に) カメラトラッキングステムにも複数の選択肢があります。試験段階と本格導入の2段階で分けて書きたいと思います。

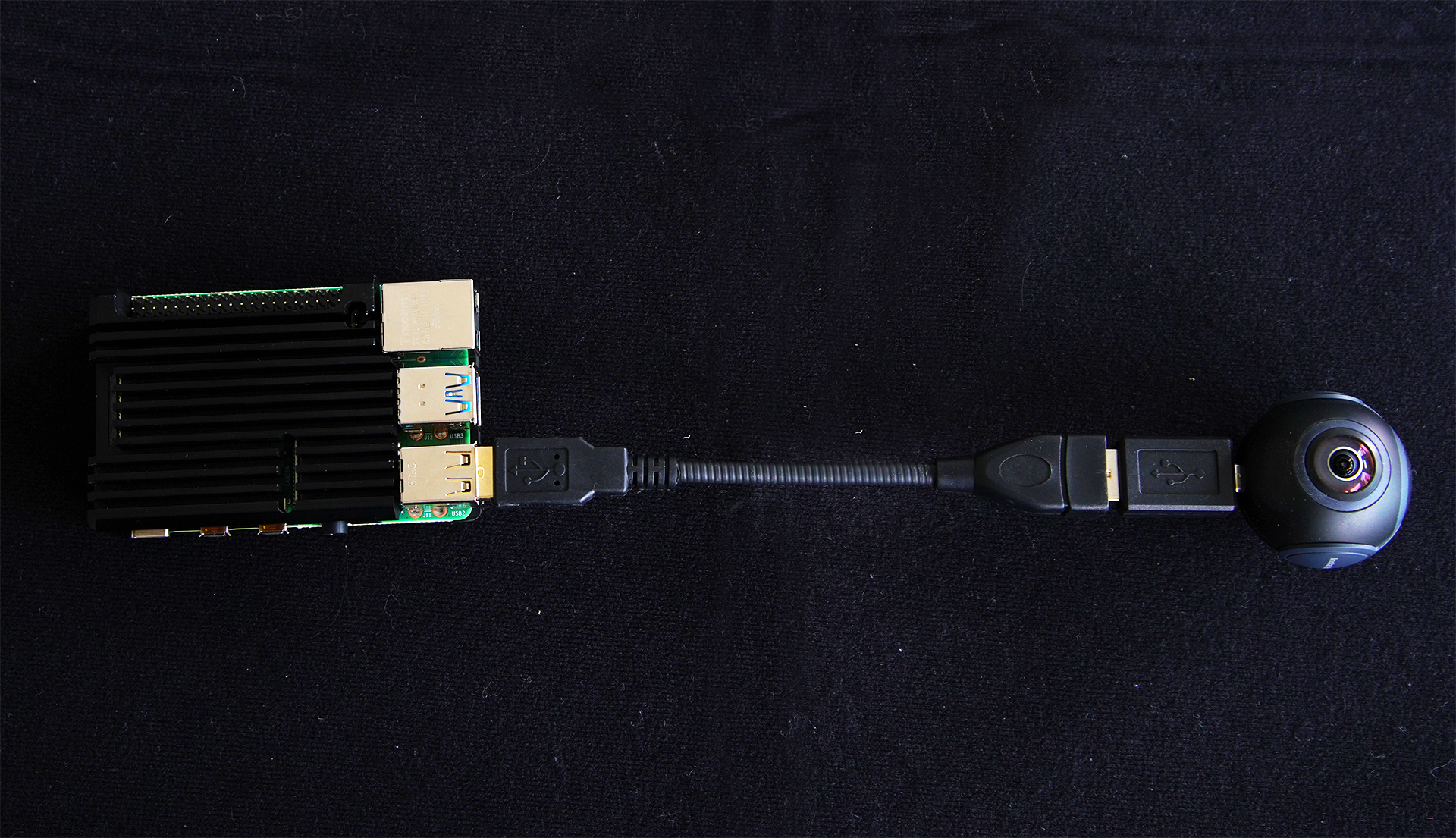

簡易にやるにはHTC Vive Tracker バーチャルプロダクションに関心を持ち始めた段階で試したのが、VRのヘッドマウントディスプレイの付属品的に販売されているHTC Vive Tracker でした。このデバイスは通常は人間の身体の⼀部に装着することで、人間のモーションキャプチャをするのに使われるのが⼀般的ですが、これをカメラにつけることでカメラの位置や動きを取ることもできます。仕組みとしては、HTC Viveのライトハウス(センサー)を2台ほど3mx3m程度の空間の対角線となるようなところに配置して、その空間内にカメラがいる限り、位置や動きを取得できます。バーチャルプロダクションの動作確認・原理確認にはこの方法でも十分機能していました。

本格的にはRedSpy、StarTracker、Ncam より広範囲で、高精度でカメラのトラッキングをするには、カメラトラッキング専用のシステムを導入する方法があります。カメラの位置や向きだけでなく、レンズ情報(ズーム率等)も後段のソフトウェアに伝える必要があるため、レンズのギヤに取り付けて使用するエンコーダ式センサも同封されていることが多いです。ここにも以下のような複数の選択肢がありました。

Stype: Red Spy Mo-sys: StarTracker Ncam 上記3例はすべて光学式と呼ばれる手法ですが、環境内に反射マーカーシールを貼るタイプであるRed SpyやStarTrackerと、マーカーレスで特徴展抽出の画像処理だけで動作するNcamという区別ができます。前者は屋内で高精度で使用する場合に向いており、後者はマーカーシールを貼るところがなくても使えるため屋外での使用に向いているそうです。私達の場合は、屋内のスタジオでの使用を想定しており、国内での実績例があり、相対的には安価であったRed Spyを導入いたしました。

6,バーチャルセットの作り方(実写 3Dスキ ャンを中心に) バーチャルセット(映像撮影時の背景に用いる3D CGモデル)も、バーチャルプロダクションでは重要なデータになります。カメラの位置や向きによって、背景の見え方も変えないと不自然になるため、背景データは3Dで使用することになります。例えばサイコロを撮影した場合、正面から撮影した場合1が見え、右側から取った場合には5、左側から撮った場合は2が見えるようになるのと同じ原理です。この3Dバーチャルセットの作り方にも大まかに分けて2種類あります。

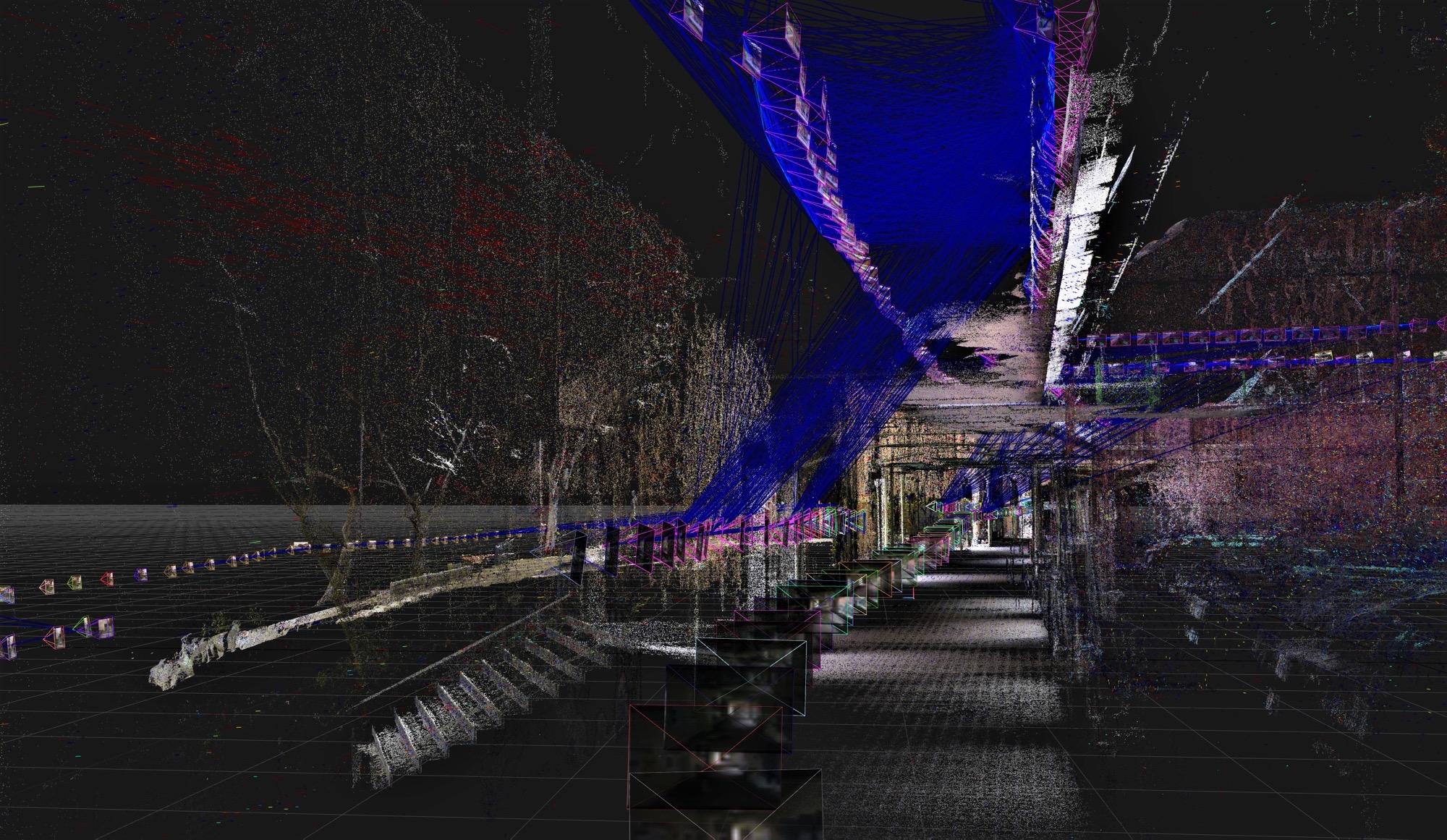

実写ベースの3Dモデリング:3Dスキャン・フォトグラ メトリ 実際に存在する建物や空間を3Dスキャンして、3Dモデルを作成する方法です。古くからあるレーザースキャナなどを用いて空間を3Dスキャンする方法や、最近のセンサーやソフトウェアの進化により急速に画質向上が図られているフォトグラメトリなどの方法があります。当社でもLeica BLK360を利用した3Dスキャンや、⼀般的な⼀眼レフカメラを用いたフォトグラメトリの両手法とも試しており、それらについては別途こちらのページ で紹介しています。

CGによるモデリング

7,照明システムとの連動方法 背景映像が上記の通りバーチャルセットになるため、リアルなスタジオで使用する照明の照度や色温度などもバーチャルセット(演者さんのいる環境)に合わせる必要が出てきます。そのため、照明も単純に明るく綺麗に演者さんを照らすだけではなく、環境に適した設定で照らす必要があります。

照明の重要性 物理的なスタジオを構築するにあたり、いまだに試行錯誤や検討が足りていないのがこのライティングです。ある程度の広さのあるスタジオのため、照明の台数は必要ですし、照明も天井に吊り下げるフラットライトやスポットライト、また三脚等で地上高に置いておくライトなど種類も多いです。このあたりのライティングについては、それだけで本⼀冊、1学期分の講義になってしまう分野なのでここでは深入りはしません。みなさん口を揃えておっしゃるのはARRIの照明 が良いということですが、とても高価なのです。

DMX信号 また、照明装置にDMX信号というフォーマットがあり、これを使うことでPCから遠隔制御ができ、かつ複数台の照明器具を接続することで、⼀⻫制御できることも今回の過程で学習しました。DMX信号に対応した照明の調達はできているものの、まだ本格運用には至っていないのでこちらも後日加筆するようにいたします。

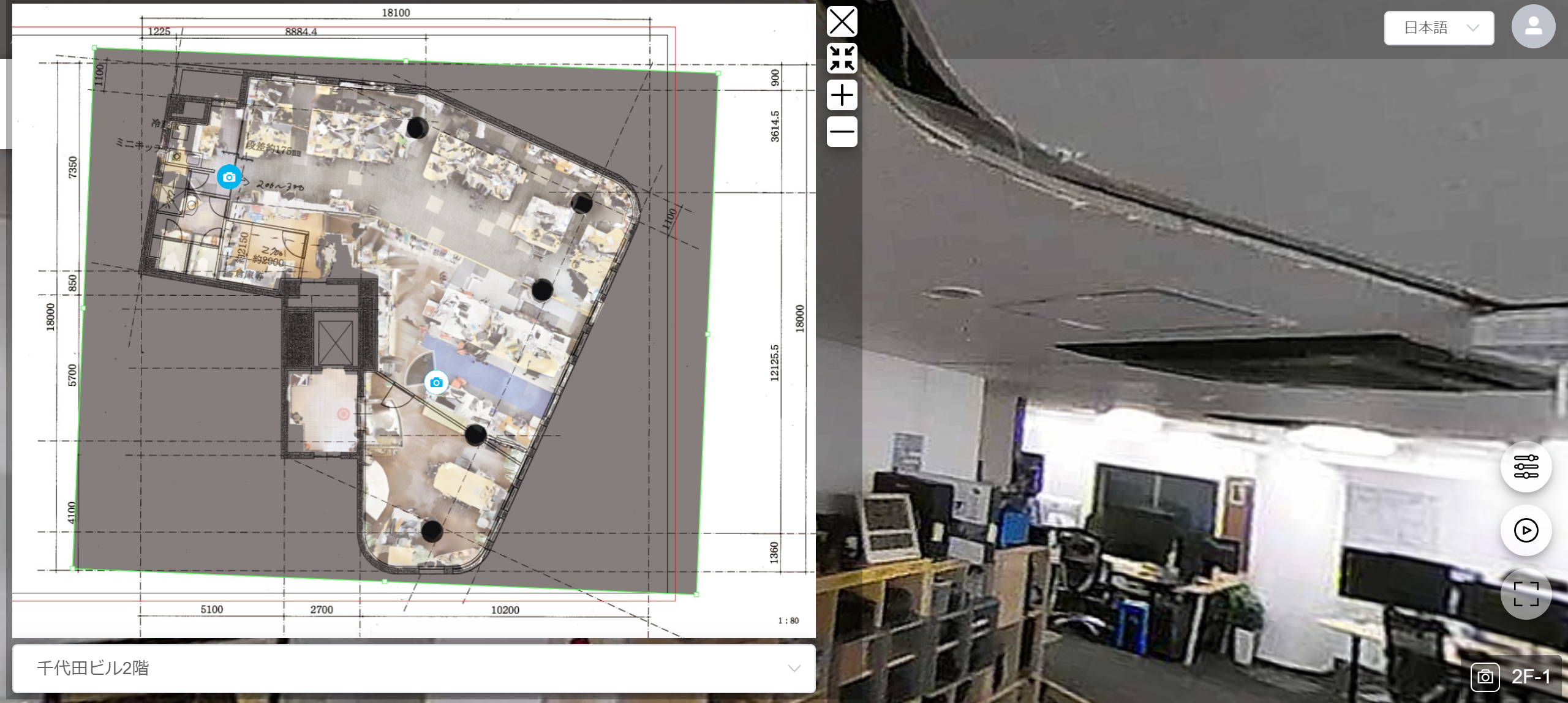

8,スタジオのレイアウトや構造 本格的な商用スタジオの多くは、大きな建物・部屋を確保できる沿岸部や郊外にあることが多いようです。⼀方で私達の場合は、ラボとスタジオでエンジニアの行き来ができるような環境を求めており、いきなり商用に⼀般公開するのではなく、短期的には研究開発にフォーカスしたスタジオにしたいということで、通常のオフィスより少し天井高を取れる都内の物件にしました。

広さ・高さ バーチャルプロダクションを手掛けるアークベルさんの平和島XRスタジオ は、幅10m x奥行き18m x 高さ4.7mというとても広い空間であり、これだけの空間だと照明の配置も理想的にできますし、複数人の同時撮影なども可能になったり、カメラワークの自由度も格段に増えます。⼀方で我々の 幅10m x 奥行き13m x 高さ2.7mというサイズは小〜中規模スタジオと呼ばれる広さであり、天高2.7m〜3.5m(Max)も必ずしも理想的な高さとは言えないようです。このあたりは他のパラメータとのトレードオフとして妥協した部分であり、⻑期的にはより広くて高いスタジオを第2弾として構築できればと思っています。

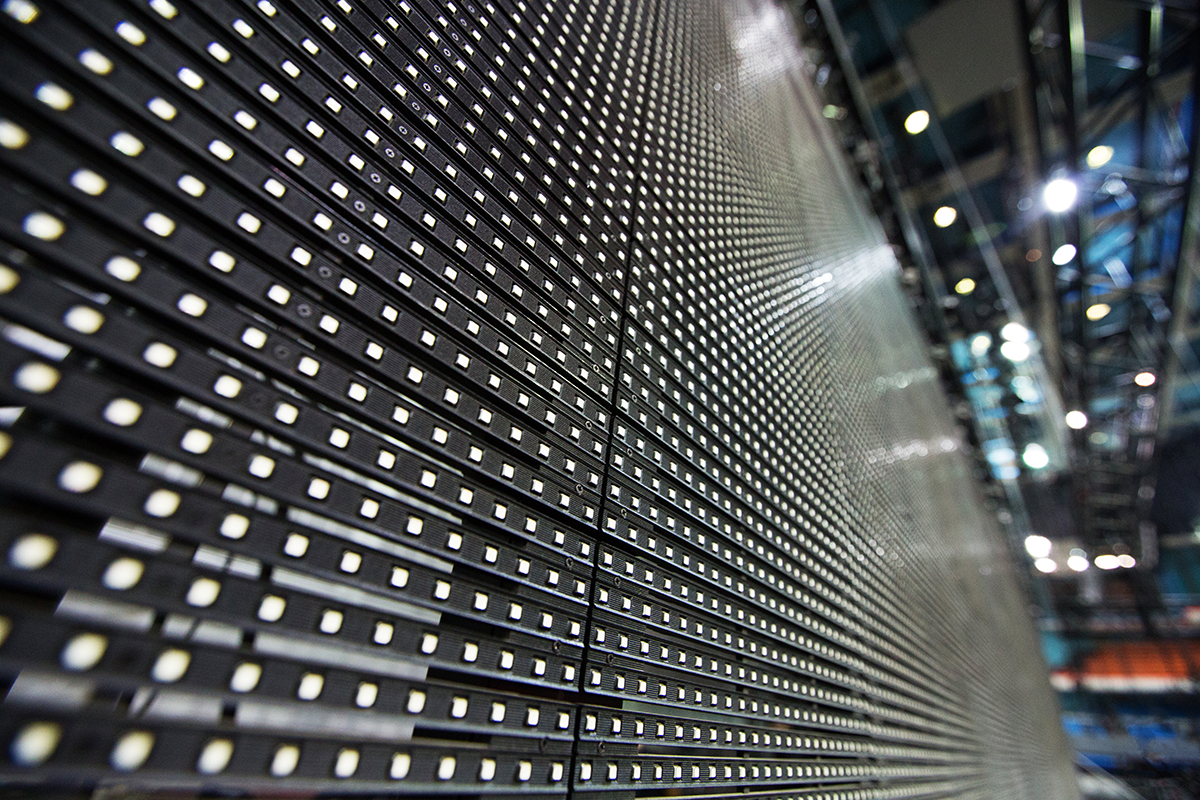

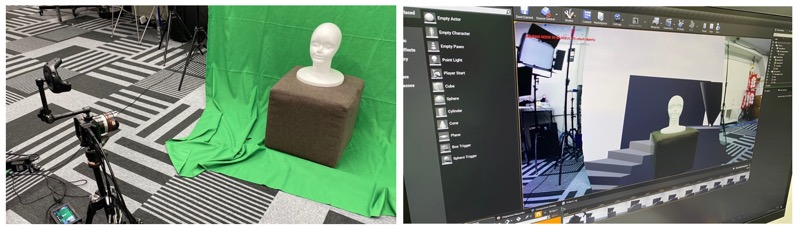

グリーンバックかLEDディスプレイか スタジオの背景環境については、グリーンバック等のカーテンを用意して、ソフトウェア側で実写とCGを合成する方式と、スタジオにLEDの壁サイズのディスプレイを配置して、演者とそのLEDに表示される映像をその場でいっぺんに撮影してしまう方式があります。グリーンバックの場合は、演者が完成イメージを頭の中で想像しながら、LEDディスプレイの場合は返しのモニターなどで実際のバーチャルセット内にいる映像を確認しながら演技・出演できるという特徴があります。

このLEDディスプレイについても、バーチャルプロダクションで用いるには再撮影可能なスペックを選ぶ必要があり、LEDのピッチ幅が1.2mm〜1.5mm以下である必要があると言われているようです。これはLEDディスプレイのスペックが低い場合、そのディスプレイをカメラで撮影した場合、モアレ(干渉縞)などの画質的な問題が発生してしまうためです。私達の環境で調達予定のLEDディスプレイも1.5mmのため、このセッティングで今後実験を開始予定です。

また、グリーンバックかLEDディスプレイかを判断する際に、撮影時にバーチャルセットが完成済みかどうかという判断基準が出てきます。グリーンバックで撮影する場合は、演者の撮影時にはバーチャルセット素材が完成していなくても、後から合成をすることになるので問題ありません。しかしLEDディスプレイを用いる場合は、演者とセットを撮影時に同時に撮影してしまうため、本番撮影時までにバーチャルセット素材を完成させなければいけないというスケジュールになります。

9,メタバース時代の映像制作

動画視聴か、メタバース体験か Oculus Riftというヘッドマウントディスプレイ(HMD)の開発者バージョンであるDK1が2016年に⼀般販売をされてから、私達はHMD向けの各種アプリケーションやメタバースシステムを開発してきました。次世代のプラットフォーム向けにシステムを開発することはとても楽しい半面、HMDの⼀般家庭やビジネスでの普及率を考えると、開発したものの拡販はあまり望めないものでした。

バーチャルプロダクションの可能性が出てきたときに思ったのが、似たような技術(3D、ゲームエンジン、仮想空間=バーチャルセット構築等)を使うものの、アウトプットが映像になるとこれは違った市場・違った顧客層向けなコンテンツ開発になりそうだ、ということでした。最終成果物が映像になることで、没入感や臨場感はVRHMDアプリケーションほどにはならないかもしれないが、これまでとは違った映像体験を実現できそうだと考えました。

メタバース空間からのライブストリーミング またVRメタバースの面白さや可能性を、HMDを持ってないユーザ層にプレゼンテーションする際に使用される方法の⼀つに、メタバース内を撮影した映像の提示があります。これはアバターに仮想的なカメラを持たせて、メタバース内を移動しながら撮影することで、ウォークスルー映像を制作することで実現されます。同じような手法で、メタバース内からアバターを用いてトークをするなどのライブストリーミングも可能になってきました。バーチャルプロダクションではこれをさらに⼀歩進めて、メタバース内からリアル人間がライブストリーミングをできるようになります。

ロケハン・プレビズ in メタバース 感染症の影響は映像制作の現場にもありました。県境を跨いだ移動の制限が政府から発せられ、屋外の撮影で必要なロケーション・ハンティング等の事前調査やそのロケ地での現場撮影すらもできなくなりました。⼀時期テレビ放送の多くが過去の番組の再放送だったことは記憶に新しいかと思います。そのような過程でバーチャルプロダクションの準備をしていた我々にとっては、安全なタイミングでロケ地の3Dモデルを制作しておいて、ロケハンやプレビズはすべてVRを利用してメタバース空間内でできるのではないか?ということでした。実空間をデジタルツイン的に再現できるのはもちろん、天気や太陽軌道をシミュレーションしたり、カメラのレンズ画角を設定したりと、これらはすべてゲームエンジンを利用すれば実現できます。いまは、そんな検討もスタジオ構築と並行して実施しています。

10,まとめ 以上、まずはバーチャルプロダクションのプロトタイピングまで、スタジオ構築までのメモを記してみました。スタジオの稼働はこれから本格化するので、随時こちらのページも加筆・修正していきたいとは思っていますが、筆不精なため次の更新がいつになるかわかりません。詳細を相談したい、スタジオ構築を考えている、バーチャルプロダクション現場を見学したい等のご要望がある場合には、こちら からご連絡を頂ければ、スタジオ見学がてらお話できるかと思います。皆様のご参考になれば幸いです。

謝辞 バーチャルプロダクションスタジオの構築にあたり、以下の方からご助言を頂きました。

インタニヤ :スタジオ構築、カメラ、レンズ、その他撮影用機材ナックイメージテクノロジー :カメラ、レンズ、カメラトラッキングシステムNGC :再撮影可能なLEDディスプレイのご助言三友 :映像機材・照明機材の販売会社FOR.A :DisguiseやLEDディスプレイの販売代理店